|

番号

|

用語

|

定義

|

対応英語

|

|

16.01.01

|

情報理論

|

情報の定量的な尺度を取り扱う理論分野。

|

information theory

|

|

16.01.02

|

通信理論

|

雑音,その他の妨害の影響下における情報の伝送に関する性質を取り扱う理論分野。

|

communication theory

|

|

16.01.03

|

情報(情報理論における)

|

事象の集合から生起する事象に関する不確実さを減らしたり取り除いたりする知識。

備考 情報理論において,“事象”は,確率論で使用されるものと同様である。事象の例には次のようなものがある。

−ある要素集合の中に特定の要素が存在すること。

−ある通報の中又はある通報の特定の位置に,ある文字又はある語が存在すること。

−ある実験から得られる結果の一つ。

|

information

|

|

16.02.01

|

通報(情報理論及び通信理論における)

|

情報の伝達を目的とする,順序付けられた文字列。

|

message (in information theory and communication theory)

|

|

16.02.02

|

情報源

|

通信系において通報が発生する部分。

|

message source●information source

|

|

16.02.03

|

通報受端

|

通信系において通報を受け取る部分。

|

message sink●information sink

|

|

16.02.04

|

通信路(通信理論における)

|

通信系において情報源と通報受端とを結ぶ部分。

備考1.符号器が情報源と通信路入力との間に,また復号器が通信路出力と通報受端との間に存在してもよい。一般に,符号器及び復号器は,通信路の一部とはみなさない。しかし,情報源及び通報受端の一部とみなす場合がある。

備考2.シャノンの情報理論においては,情報源からの通報に対して通報受端が受け取る通報の条件付き生起確率で,通信路は特徴付けられる。

|

channel (in communication theory)

|

|

16.02.05

|

2元対称通信路

|

2進文字から成る通報を伝送する通信路であり,伝送したある文字がもう一方の文字に変化してしまう条件付き確率が等しい性質をもつもの。

|

symmetric binary channel

|

|

16.02.06

|

定常情報源

|

通報の生起確率が時刻に依存しない情報源。

|

stationary message source●stationary information source

|

|

16.03.01

|

選択情報量

|

互いに排反な事象から成る有限集合中の事象の数の対数。数学的には,この選択情報量は,

H_0=log n

で表される。ここで,n は事象の数である。

備考1.16.01.03の備考参照。

備考2.対数の底によって単位が定まる。よく使われる単位には次のものがある。

対数の底が2のときはシャノン(記号は Sh)。

対数の底がeのときはナット(記号は nat)。

対数の底が10のときはハートレー(記号は Hart)。

単位の変換表を次に示す。

1 Sh=0.693 nat=0.301 Hart

1 nat=1.443 Sh=0.434 Hart

1 Hart=3.322 Sh=2.303 nat

備考3.選択情報量は,事象の生起確率に対して独立である。

備考4.有限個の互いに排反な事象から成る有限集合の中から,特定の事象を選択するために必要な,b 個の選択肢からの選択回数は,b を底とする対数で定義した選択情報量の小数部分を切り上げた整数に等しい。ただし,b は整数とする。

例 {a,b,c} を三つの事象から成る集合とすると,この集合の選択情報量は次のとおり。

H_0=(log_2 3)Sh=1.585 Sh

=(log_e 3)nat=1.098 nat

=(log_10 3)Hart=0.477 Hart

|

decision content

|

|

16.03.02

|

情報量

|

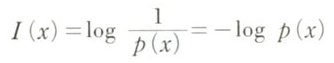

確率事象の生起を知ることによって伝えられる情報の尺度。この尺度はその事象の生起確率の逆数の対数に等しく,数学的には,

で表される。ここで,p(x) は事象 x の生起確率である。

備考1.16.01.03の備考参照。

備考2.生起確率が等しい事象から成る集合では,各事象の情報量はその集合の選択情報量に等しい。

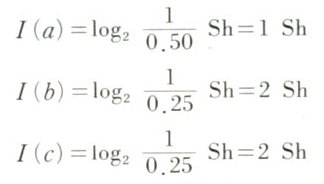

例 {a,b,c} を三つの事象から成る集合とし,各事象の生起確率を p(a)=0.5,p(b)=0.25 及び p(c)=0.25 とする。これらの事象の情報量は次のとおり。

|

information content

|

|

16.03.03

|

エントロピー●平均情報量

|

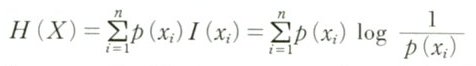

有限の完全事象系の中から,いずれの事象が生起したかを知ることによって伝えられる情報量の平均値。数学的には,

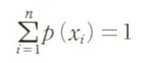

で表される。ここで,X={x_1, ……, x_n} は事象 x_i (i=1, ……, n)の集合,I(x_i) は事象 x_i の情報量,及び p(x_i) は事象 x_i の生起確率であって,

を満たすものとする。

備考 完全事象系とは,それを構成する事象が互いに排反であり,すべての事象の和集合が全事象に一致する事象系をいう。

例 {a,b,c} を三つの事象から成る集合とし,各事象の生起確率を p(a)=0.5,p(b)=0.25 及び p(c)=0.25 とする。この集合のエントロピーは次のとおり。

H(X)=p(a)I(a)+p(b)I(b)+p(c)I(c)=1.5 Sh

|

entropy●average information content●negentropy(使用しないほうがよい)

|

|

16.03.04

|

相対エントロピー

|

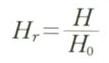

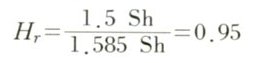

エントロピー H と選択情報量 H_0 との比 H_r。数学的には,

で表される。

例 {a,b,c} を三つの事象から成る集合とし,各事象の生起確率を p(a)=0.5,p(b)=0.25 及び p(c)=0.25 とする。この集合の相対エントロピーは次のとおり。

|

relative entropy

|

|

16.03.05

|

冗長量(情報理論における)

|

選択情報量 H_0 とエントロピー H との差 R。数学的には,

R=H_0−H

で表される。

備考 通常,通報は,適切な符号を用いて,より少ない文字数で表現できる。冗長量は,その符号化によって達成される通報の平均長の減少量と考えられる。

例 {a,b,c} を三つの事象から成る集合とし,各事象の生起確率を p(a)=0.5,p(b)=0.25 及び p(c)=0.25 とする。この集合の冗長量は次のとおり。

R=1.585 Sh−1.500 Sh=0.085 Sh

|

redundancy (in information theory)

|

|

16.04.01

|

冗長度(情報理論における)

|

冗長量 R と選択情報量 H_0 との比 r。数学的には,

で表される。

備考 冗長度は相対エントロピー H_r の1の補数に等しい。すなわち,

r=1−H_r

である。

|

relative redundancy

|

|

16.04.02

|

条件付き情報量

|

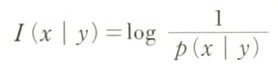

ある事象 y が生起したという条件下で他の事象 x の生起を知ることによって伝えられる情報の定量的な尺度。この尺度は事象 y が生起したという条件下の事象 x の条件付き確率 p(x | y) の逆数に等しい。数学的には,この尺度 I(x | y) は,

で表される。

備考 条件付き情報量 I(x | y) は,x 及び y の結合情報量 I(x,y) から y の情報量 I(y) を引いた差に等しい。すなわち,

I(x | y)=I(x,y)−I(y)

である。

|

conditional information content

|

|

16.04.03

|

結合情報量

|

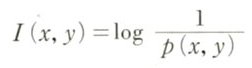

二つの事象 x 及び y が同時に生起したことを知ることによって伝えられる情報の定量的な尺度。この量は両事象の結合確率 p(x,y) の逆数の対数に等しい。数学的には,この尺度 I(x,y) は,

で表される。

|

joint information content

|

|

16.04.04

|

条件付きエントロピー●条件付き平均情報量

|

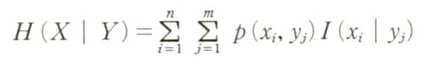

完全事象系の中から一つの事象が生起したという条件下で,他の完全事象系の中から一つの事象が生起したことを知ることによって伝えられる条件付き情報量の平均値。数学的には,この尺度は,

で表される。ここで,X={x_1, ……, x_n} は事象 x_i (i = 1, ……, n) の集合,Y={y_1, ……, y_m} は事象 y_j (j = 1, ……, m) の集合,I(x_i | y_j) は y_j が生起したという条件下で x_i の条件付き情報量,及び p(x_i,y_j) は両事象の結合確率である。

|

conditional entropy●mean conditional information content●average conditional information content

|

|

16.04.05

|

あいまい量●あいまい度

|

一つの通信路によって情報源に接続されている通報受端において特定の通報の集合が生起したという条件下で,情報源においてある通報の集合が生起する条件付きエントロピー。

備考 あいまい量は,雑音のある通信路で影響を受けた受信通報を訂正するために,通報受端において供給しなければならない1通報当たりの付加的情報量の平均値である。

|

equivocation

|

|

16.04.06

|

散布量●散布度

|

一つの通信路によって通報受端に接続されている情報源において特定の通報の集合が生起したという条件下で,通報受端においてある通報の集合が生起する条件付きエントロピー。

|

irrelevance●prevarication●spread

|

|

16.04.07

|

伝達情報量●相互情報量

|

事象 x の生起を知ることによって伝えられる情報量 I(x) と,他の事象 y が生起したという条件下で同じ事象 x の生起を知ることによって伝えられる条件付き情報量 I(x | y) との差。数学的には,この尺度 T(x,y) は,

Y(x,y)=I(x)−I(x | y)

で表される。

備考1.二つの事象 x 及び y の例として,ある通信路の情報源での通報,及び通報受端での通報があげられる。

備考2.伝達情報量は

T(x,y)=I(x)+I(y)−I(x,y)

とも表せる。ここで,I(y) は事象yの情報量,I(x,y) は両事象の結合情報量である。このことから,伝達情報量が x 及び y に関して対称であって,

Y(x,y)=T(y,x)

であることがわかる。

|

transinformation●transinformation content●transferred information●transmitted information●mutualinformation

|

|

16.04.08

|

平均伝達情報量

|

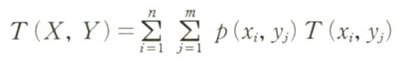

完全事象系の中から一つの事象が生起したという条件下で,他の完全事象系の中から一つの事象が生起したことを知ることによって伝えられる伝達情報量の平均値。数学的には,この尺度は

で表される。ここで,X={x_1, ……, x_n} は事象 x_i (i=1, ……, n) の集合,Y={y_1, ……, y_m} は事象 y_j (j=1, ……, m) の集合,T(x_i,y_j) は x_i 並びに y_j の伝達情報量,及び p(x_i,y_j) は両事象の結合確率である。

備考1.平均伝達情報量は X 及び Y に関して対称である。二つの事象集合 X 及び Y があったとき,平均伝達情報量は,X のエントロピーと,Y に関する X の条件付きエントロピーとの差に等しい。すなわち,

T(X,Y)=H(X)−H(X | Y)=H(Y)−H(Y | X)=T(Y,X)

である。

備考2.X を情報源での特定の通報の集合とし,Y を通報受端での特定の通報の集合としたとき,平均伝達情報量は,その通信路を通して送られる情報の尺度である。平均伝達情報量は,情報源でのエントロピーとあいまい量との差に等しく,通報受端でのエントロピーと散布量との差にも等しい。

|

mean transinformation content●average transinformation content

|

|

16.04.09

|

1文字当たりの平均エントロピー●1文字当たりの平均情報量●1文字当たりの情報速度

|

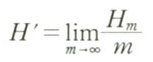

定常情報源から出されるすべての通報に対する1文字当たりのエントロピーの平均値。数学的には,この尺度 H' は極限値

で表される。ここで,H_m は定常情報源から出される m 個の文字から成る全系列についてのエントロピーである。

備考1.1文字当たりの平均エントロピーは,Sh/文字などの単位で表現される。

備考2.情報源が定常でないならば,この極限値は存在しない場合がある。

|

character mean entropy●character mean information content●character average information content●character information rate

|

|

16.04.10

|

情報速度●平均情報速度

|

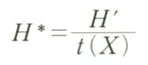

1文字当たりの平均エントロピー H' を文字の時間長さの平均値で割ったもの。数学的には,この尺度 H* は

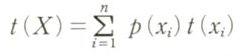

で表される。ここで X={x_1, ……, x_n} は文字 x_i (i=1, ……, n) の集合であり,

は p(x_i) で生じる文字 x_i の時間長さ t(x_i) の平均値である。

備考 平均情報速度はSh/秒などの単位で表現される。

|

information rate●average information rate

|

|

16.04.11

|

1文字当たりの平均伝達情報量

|

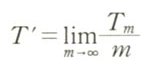

定常情報源から出されるすべての通報に対する平均伝達情報量の1文字当たりの平均値。数学的には,この尺度 T' は,極限値

で表される。ここで,T_m は m 個の文字から成る入力及び出力の系列間の平均伝達情報量である。

備考 1文字当たりの平均伝達情報量は,Sh/文字などの単位で表現される。

|

character mean transinformation content

|

|

16.04.12

|

平均伝達情報速度

|

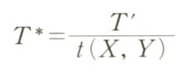

1文字当たりの平均伝達情報量 T' を,入力文字及び出力文字の対の時間の平均値で割ったもの。数学的には,この尺度 T* は,

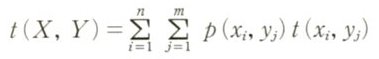

で表される。ここで,X={x_1, ……, x_n} は入力文字 x_i (i=1, ……, n)の集合,Y={y_1, ……, y_m} は出力文字 y_j (j=1, ……, m) の集合,及び

は結合確率 p(x_i,y_j) で生起する文字の組 (x_i,y_j) の時間長 t(x_i,y_j) の平均値である。

備考 平均伝達情報速度は,Sh/秒などの単位で表現される。

|

average transinformation rate

|

|

16.04.13

|

通信路容量

|

情報源から通信を伝送する際の通信路の能力の尺度。1文字当たりの平均伝達情報量の最大値又は平均伝達情報速度の最大値で表現される。この最大値は適当な符号を用いれば,任意の小さな誤り確率で達成できる。

|

channel capacity

|